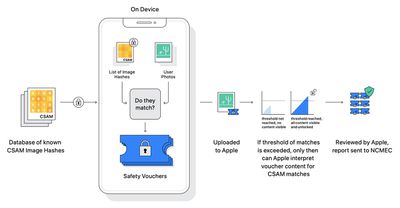

На этой неделе Apple объявила, что начиная с конца этого года с выходом iOS 15 и iPadOS 15 компания сможет обнаруживать известные изображения материалов сексуального насилия над детьми (CSAM), хранящиеся в iCloud Фото, что позволит Apple сообщать об этих случаях в Национальный центр по делам пропавших и эксплуатируемых детей, некоммерческую организацию, которая сотрудничает с правоохранительными органами по всей территории Соединенных Штатов.

Эти планы вызвали опасения у некоторых исследователей безопасности и других сторон, что Apple в конечном итоге может быть вынуждена правительствами добавлять изображения, не являющиеся CSAM, в список хешей для злонамеренных целей, например, для подавления политического активизма.

«Независимо от того, насколько благими ни были намерения, Apple разворачивает массовое наблюдение для всего мира», — заявил известный разоблачитель Эдвард Сноуден, добавив, что «если сегодня они могут сканировать педофилию, то завтра они могут сканировать что угодно». Некоммерческая организация Electronic Frontier Foundation также раскритиковала планы Apple, заявив, что «даже тщательно задокументированный, продуманный и узкоспециализированный бэкдор остается бэкдором».

Чтобы устранить эти опасения, Apple сегодня предоставила дополнительные комментарии о своих планах.

Известная система обнаружения CSAM от Apple будет ограничена Соединенными Штатами на момент запуска, и для решения потенциальной проблемы попыток некоторых правительств злоупотреблять системой Apple подтвердила MacRumors, что компания будет рассматривать любое возможное глобальное расширение системы на основе отдельных стран после проведения юридической оценки. Apple не предоставила никаких временных рамок для глобального расширения системы, если такой шаг вообще когда-либо произойдет.

Apple также коснулась гипотетической возможности того, что конкретный регион мира решит коррумпировать организацию по безопасности в попытке злоупотребить системой, отметив, что первым уровнем защиты системы является неуказанный порог, прежде чем пользователь будет помечен за наличие неприемлемых изображений. Даже если порог будет превышен, Apple заявила, что ее процесс ручного обзора послужит дополнительным барьером и подтвердит отсутствие известных изображений CSAM. Apple заявила, что в конечном итоге не будет сообщать помеченному пользователю в NCMEC или правоохранительные органы, и что система будет работать точно так, как задумано.

Apple также выделила некоторых сторонников системы, при этом некоторые стороны высоко оценили компанию за ее усилия по борьбе с детским насилием.

«Мы поддерживаем постоянное развитие подхода Apple к онлайн-безопасности детей», — сказал Стивен Балкам, генеральный директор Института безопасности семьи в Интернете. «Учитывая трудности, с которыми сталкиваются родители при защите своих детей в Интернете, крайне важно, чтобы технологические компании постоянно совершенствовали свои инструменты безопасности, чтобы реагировать на новые риски и фактический вред».

Apple признала, что не существует универсального решения в отношении потенциального злоупотребления системой, но компания заявила, что намерена использовать систему исключительно для обнаружения известных изображений CSAM.

Примечание: Из-за политического или социального характера обсуждения этой темы, ветка обсуждения находится в нашем Политическая новость форуме. Все участники форума и посетители сайта могут читать и следить за веткой, но публикация разрешена только участникам форума, имеющим не менее 100 сообщений.