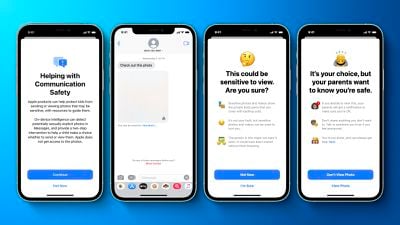

Сегодня Apple опубликовала документ, в котором более подробно рассказывается о функциях защиты детей, анонсированных на прошлой неделе, включая принципы проектирования, требования к безопасности и конфиденциальности, а также соображения по модели угроз.

План Apple по обнаружению известных изображений материалов, связанных с сексуальным насилием над детьми (CSAM), хранящихся в iCloud Photos, вызвал особую противоречивость и беспокойство некоторых исследователей в области безопасности, некоммерческой организации Electronic Frontier Foundation и других, относительно потенциальной возможности злоупотребления системой правительствами в качестве формы массовой слежки.

Документ призван развеять эти опасения и вновь подтвердить некоторые детали, прозвучавшие ранее в интервью с главой отдела программного обеспечения Apple Крейгом Федериги, в том числе то, что Apple ожидает установить начальный порог совпадений в 30 известных изображений CSAM, прежде чем учетная запись iCloud будет помечена для ручной проверки компанией.

Apple также заявила, что база данных известных изображений CSAM на устройстве содержит только записи, которые были независимо предоставлены двумя или более организациями по защите детей, работающими в разных суверенных юрисдикциях и не находящимися под контролем одного и того же правительства.

Система разработана таким образом, чтобы пользователь не нуждался в доверии к Apple, какой-либо другой отдельной организации или даже к набору потенциально сговаривающихся организаций из одной суверенной юрисдикции (то есть, находящихся под контролем одного правительства), чтобы быть уверенным в том, что система работает так, как заявлено. Это достигается за счет нескольких взаимосвязанных механизмов, включая внутреннюю проверяемость одного образа программного обеспечения, распространяемого по всему миру для выполнения на устройстве, требование, чтобы любые хэши изображений, включенные в зашифрованную базу данных CSAM на устройстве, предоставлялись независимо двумя или более организациями по защите детей из разных суверенных юрисдикций, и, наконец, процесс проверки человеком для предотвращения любых ошибочных сообщений.

Apple добавила, что опубликует на своем веб-сайте документ поддержки, содержащий корневой хэш зашифрованной базы данных хэшей CSAM, включенной в каждую версию каждой операционной системы Apple, поддерживающей эту функцию. Кроме того, Apple заявила, что пользователи смогут проверять корневой хэш зашифрованной базы данных, присутствующий на их устройстве, и сравнивать его с ожидаемым корневым хэшем в документе поддержки. Сроки для этого не были указаны.

В служебной записке, полученной Марком Гурманом из Bloomberg, Apple сообщила, что независимый аудитор также проведет проверку системы. В служебной записке отмечалось, что сотрудники розничной торговли Apple могут получать вопросы от клиентов о функциях защиты детей, и содержалась ссылка на FAQ, которым Apple поделилась ранее на этой неделе, как на ресурс, который сотрудники могут использовать для ответов на вопросы и предоставления большей ясности и прозрачности клиентам.

Первоначально Apple заявила, что новые функции защиты детей появятся на iPhone, iPad и Mac с обновлениями программного обеспечения позже в этом году, и компания заявила, что функции будут доступны только в США на момент запуска. Несмотря на критику, Apple сегодня заявила, что не внесла никаких изменений в эти сроки развертывания функций для пользователей.